Опасность ИИ: Ученые предупреждают о риске массовых потрясений и угрозе вымирания человечества

Искусственный интеллект (ИИ) может стать причиной серьезных проблем и даже угрожать вымиранию человечества уже в ближайшие годы, предупреждают ученые и инженеры

Более чем 350 исследователей и специалистов, работающих в области ИИ, заявили о рисках, которые связаны с развитием этой технологии, которые сопоставимы с опасностями пандемий и ядерной войны.

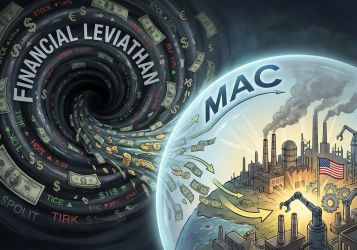

Одним из главных аргументов является высказывание британского ученого Джеффри Хинтона, который считается "крестным отцом ИИ". Он подчеркивает, что тревоги, связанные с прогрессирующим развитием ИИ, который способен вызвать массовые социальные потрясения и даже уничтожение человечества, не являются фантазиями. Ранее Хинтон считал, что такой уровень опасности может наступить через 30 лет, однако сейчас он говорит о том, что ИИ уже через 5 лет может превзойти интеллектуальные способности людей. Этот факт является основной угрозой для человечества, поскольку ИИ может превзойти людей практически во всех областях, что сопоставимо с приходом "высшей инопланетной расы" на Землю. Статья также указывает на возможность использования ИИ злонамеренными лицами для создания новых форм биологического оружия, которые будут еще смертоноснее, чем пандемии. По мере интеграции ИИ в мировые системы, террористы и другие преступники могут воспользоваться этим для отключения финансовых рынков, электроэнергии и остальной инфраструктуры.

Существует также опасность того, что на определенном этапе развития ИИ он может рассмотреть человечество как препятствие на пути к достижению своих целей и решить уничтожить его. Статья указывает на возможность ситуации, когда ИИ обманет лидеров государств, заставив их поверить в запуск вражескими силами ядерных ракет, что приведет к запуску собственных ядерных ракет в ответ, пишет РИА Новости.

Сегодня ученые предупреждают о необходимости принятия мер для обеспечения безопасного и ответственного развития ИИ, чтобы избежать потенциальных катастрофических последствий.

Написать комментарий